数据挖掘包含两大部分:数据挖掘实验引擎、数据挖掘服务引擎数据挖掘包含两大部分:数据挖掘执行引擎、数据挖掘服务引擎

数据挖掘实验引擎:数据挖掘执行引擎:

- 负责接收smartbi 发送执行请求。

- 通过解析执行定义,生成spark 计算任务或python计算任务,分别发送给spark集群或python集群。

- 本身并不承担计算任务,只负责计算任务的调度跟分发。

数据挖掘服务引擎:

- 提供模型预测服务给第三放系统调用

数据挖掘实验引擎和服务引擎可部署在同一台服务器中,也可以分开部署在不同服务器中。数据挖掘执行引擎和服务引擎可部署在同一台服务器中,也可以分开部署在不同服务器中。

| 注意 | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| ||||||||||||||||

单机部署数据挖掘组件环境如下:

|

...

| 注意 | ||

|---|---|---|

| ||

部署smartbi服务器的/etc/hosts,需要添加所有数据挖掘组件的主机和IP地址映射 |

2.安装数据挖掘-

...

执行引擎

1、解压Smartbi-engine安装包到指定的安装目录

...

| 注意 | ||

|---|---|---|

| ||

由于文档中服务引擎与执行引擎部署在同一台服务器,所以无需重复设置系统环境。 如果服务引擎与执行引擎部署在不同服务器时,服务引擎系统环境设置可参考实验引擎的配置。如果服务引擎与执行引擎部署在不同服务器时,服务引擎系统环境设置可参考执行引擎的配置。 |

1、启动数据挖掘服务引擎

| 代码块 | ||||

|---|---|---|---|---|

| ||||

cd /data/smartbi-mining-engine-bin/engine/sbin/ ./service-daemon.sh start |

4.测试数据挖掘

| 注意 |

|---|

| 此处仅测试数据挖掘本地模式,未连接Spark等计算节点 |

第一步:数据挖掘执行引擎连接测试:

| 注意 |

|---|

引擎和服务所在的主机名不能带有小数点或下划线。 |

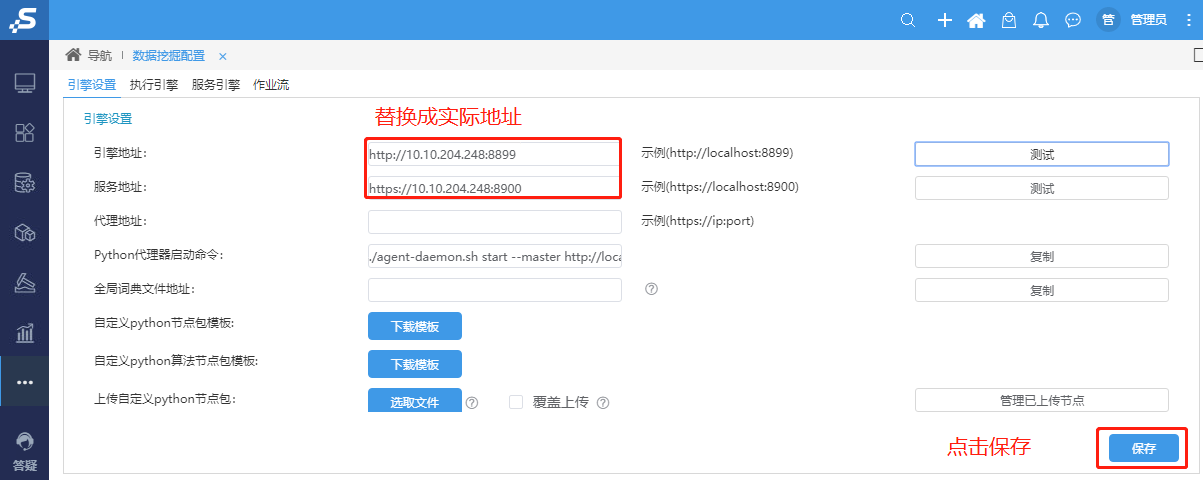

(1)浏览器访问Smartbi,打开系统运维–系统选项–引擎设置

(2)在引擎设置页面输入引擎地址和服务地址后,点击测试连接

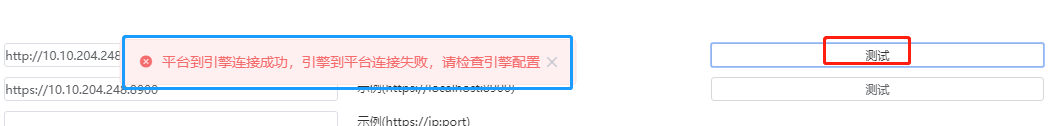

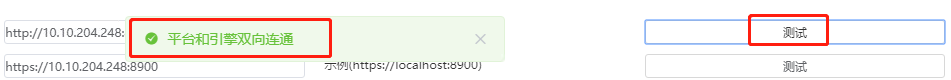

由于第一次部署数据挖掘服务,当前引擎不知道smartbi服务器的实际地址,所以会提示“平台到引擎连接成功,引擎到平台连接失败,请检查引擎配置”的警告。需要先点击保存按钮,然后再到执行引擎和服务引擎设置smartbi的地址,并保存。最后回到引擎设置点击 测试连接 才能提示“平台和引擎双向连通”

| 注意 |

|---|

如果测试连接后没有保存,则执行引擎和服务引擎可能会显示空白页面 |

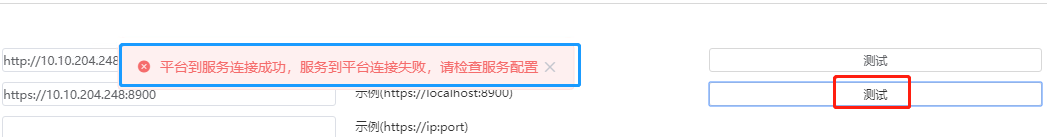

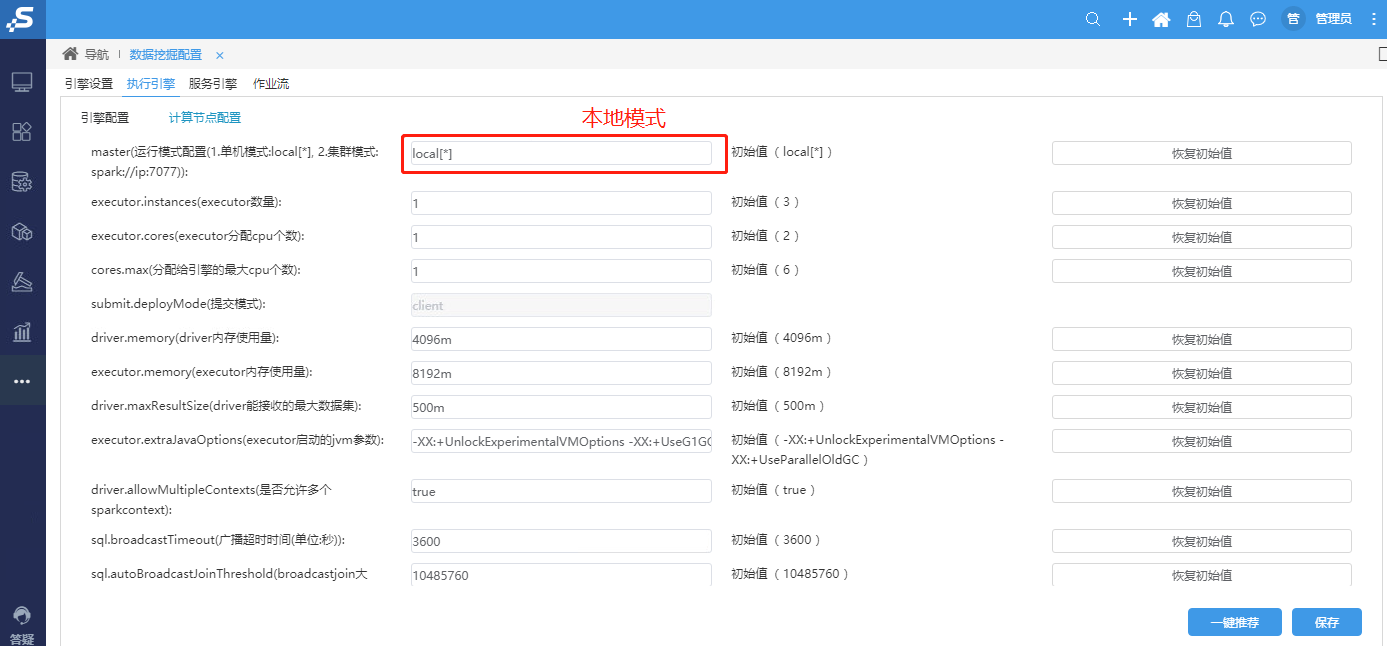

(3)打开系统运维--系统选项–执行引擎--引擎配置,如下图所示(具体配置根据实际部署环境修改):

(4)打开系统运维--系统选项–执行引擎--计算节点配置,如下图所示:(如未部署Spark,计算节点配置使用初始值)

若当前已部署好Spark,计算节点配置如下图所示:(具体配置根据实际部署环境修改):

重点配置红框地方,第一个框填写spark master连接地址,其它选项配置策略如下:

- instances * executor.memory <= spark可分配的内存数 * 0.7(例如 52G * 0.7 = 36)

- instances * executor.cores <= spark可分配的cpu核数 * 0.7(例如: 32核 * 0.7 = 22)

- max = executor.instances * executor.cores

默认情况下,executor.memory 配置为8G,除非总的内存比8G还小,根据上面策略,其它选项配置如下

- instances = spark可分配的内存数 * 0.7 / executor.memory = 52 * 0.7 / 8 = 4

- cores = spark可分配的cpu核数 * 0.7 / executor.instances = 32 * 0.7 / 4 = 5

- max = executor.instances * executor.cores = 4 * 5 = 20

| 注意 |

|---|

给引擎分配的cpu个数、内存大小,不能超过spark服务器拥有的cpu个数、总内存的大小,否则引擎会启动失败。 |

| 注意 |

|---|

需采用先部署挖掘引擎在部署Spark的部署逻辑。 |

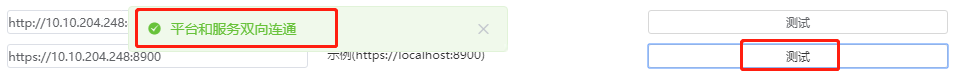

第二步:数据挖掘服务引擎连接测试:

(1)打开系统运维--系统选项–服务引擎--引擎配置,如下图所示(具体配置根据实际部署环境修改):

(2)执行引擎和服务引擎完成设置、保存后回到引擎设置,对引擎地址、服务地址重新点击测试,弹出平台和引擎双向连通,说明设置成功,进行保存。如下图所示。

5.运维操作1、启动/重启/查看实验引擎1、数据挖掘连接测试:

①浏览器访问Smartbi,打开系统运维–数据挖掘配置–引擎设置,引擎地址和服务地址设置成正确的数据挖掘引擎地址,并点击保存

| 注意 | ||

|---|---|---|

| ||

修改引擎和服务地址后,需要点击保存,否则执行引擎和服务引擎可能会显示空白页 |

配置数据挖掘地址后,首次测试引擎地址,会提示“平台到引擎连接成功,引擎到平台连接失败,请检查引擎配置”

首次测试服务地址则会提示“平台到服务连接成功,服务到平台连接失败,请检查服务配置”

②打开系统运维–数据挖掘配置–执行引擎--引擎配置,参考下图修改smartbi地址(根据实际环境修改),修改完成后点击保存:

③打开系统运维–数据挖掘配置–执行引擎--计算节点配置,参考下图设置,修改完成后点击保存

由于未部署spark计算节点,需要设置成单机local模式:

④打开系统运维–数据挖掘配置–服务引擎,参考下图修改smartbi地址(根据实际环境修改),修改完成后点击保存:

⑤执行引擎和服务引擎完成设置、保存后,返回 系统运维–数据挖掘配置–引擎设置,重新点击测试,如下提示表示配置成功:

3、运维操作

1、启动/重启/查看执行引擎

| 代码块 | ||||

|---|---|---|---|---|

| ||||

cd /opt/smartbi-mining-engine-bin/engine/sbin ./experiment-daemon.sh restart #重启实验引擎#重启执行引擎 ./experiment-daemon.sh stop #停止实验引擎#停止执行引擎 ./experiment-daemon.sh status #查看实验引擎运行状态#查看执行引擎运行状态 ./service-daemon.sh restart #重启服务引擎 ./service-daemon.sh stop #停止服务引擎 ./service-daemon.sh status #查看服务引擎运行状态 |

2、测试实验引擎2、测试执行引擎

参考 测试数据挖掘集群及其组件

3、日志查看

数据挖掘的日志路径:/opt/smartbi-mining-engine-bin/logs

安装部署或者使用中有问题,可能需要根据日志来分析解决。

4、设置数据挖掘开机启动

进入/etc/init.d目录,创建数据挖掘-实验引擎启动配置文件执行引擎启动配置文件

| 代码块 | ||

|---|---|---|

| ||

vi /etc/init.d/mining-engine |

...