...

SmartbiV9.5到V10版本升级内容如下:

| 组件 | V95版本 | V10版本 | 更新内容 | 备注 |

|---|

| Smartbi | √ | √ | Smartbi版本升级到V10 |

|

| Smartbi-OLAP-Server | × | √ | 新增组件Smartbi-OLAP-Server |

...

...

| V10不支持Infobright,需要更换为SmartbiMPP |

| 数据挖掘 | √ | √ |

...

| 各部件的更新 | 包括数据挖掘实验引擎、服务引擎、spark、python更新升级,新增hadoop部署 |

| 注意 |

|---|

|

版本升级前,请提前备份好数据,避免因为升级问题导致数据异常 |

一、Smartbi更新war包

获取V10版本的Smartbi安装包。更新的详细方法,请参考:

数据挖掘引擎安装包版本要和smartbi的war包版本一致,更新时需要同步更新Python节点中的引擎包。

1、Spark版本升级

| 注意 |

|---|

|

需要使用Smartbi提供的Spark3.1.2安装包部署 |

1. 停止旧版本Spark

进入spark安装目录,执行命令停止spark2.4服务

| 代码块 |

|---|

|

cd /data/spark-2.4.0-bin-hadoop2.7/sbin/ #注意进入实际spark部署目录

./stop-all.sh

|

| 注意 |

|---|

|

注意,如果出现无法停止情况,可以通过jps查看Spark服务(Spark的进程名有Master,Worker,CoarseGrainedExecutorBackend)进程id,然后 kill -9 进程id |

2.配置系统免密登陆

登陆服务器,生成密钥

输入ssh-keygen后,连续按三次回车,不用输入其它信息。

复制公钥到文件中:

| 代码块 |

|---|

|

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys |

测试是否设置成功

示例:

| 代码块 |

|---|

|

ssh root@10-10-204-249 |

如果不用输入密码,表示配置成功

3.安装Spark

解压Spark到指定目录

| 代码块 |

|---|

|

tar -zxvf spark-3.1.2-bin-hadoop3.2.tgz -C /data |

启动Spark

| 代码块 |

|---|

|

cd /data/spark-3.1.2-bin-hadoop3.2.tgz/sbin

./start-all.sh |

4. 检查Spark

在浏览器中输入:http://master节点的ip:8080,查看集群状态

Image Removed

Image Removed

在spark节点提交任务测试进入/data/spark-3.1.2-bin-hadoop3.2/bin目录,执行以下命令(注意将”节点IP”替换对应的IP或主机名)

| 代码块 |

|---|

./spark-submit --class org.apache.spark.examples.SparkPi --master spark://节点IP:7077 /data/spark-3.1.2-bin-hadoop3.2/examples/jars/spark-examples_2.12-3.0.0.jar 100 |

Image Removed

Image Removed

运行得出圆周率Pi的近似值3.14即部署成功。

5. 运维操作

启动/停止spark服务

| 代码块 |

|---|

cd /data/spark-3.1.2-bin-hadoop3.2/sbin

./start-all.sh #启动spark

./stop-all.sh #停止spark |

Spark集群部署参考文档:部署Spark集群

6. Smartbi连接Spark

浏览器访问smartbi,打开系统运维–数据挖掘配置–执行引擎--计算节点配置,参考下图设置,修改完成后点击保存

配置spark计算节点:

Image Removed

Image Removed

配置Spark节点资源,点击一键推荐,系统会根据Spark work节点的服务器资源,生成推荐的配置(如果使用推荐值,记得点击保存,否则配置不生效):

Image Removed

Image Removed

Spark升级配置完成。

2、安装Hadoop组件

数据挖掘V10版本增加了Hadoop节点中间数据存储,可根据需要部署。

1、系统环境准备

1.1防火墙配置

为了便于安装,建议在安装前关闭防火墙。使用过程中,为了系统安全可以选择启用防火墙,但必须启用服务相关端口。

1.关闭防火墙

临时关闭防火墙

| 代码块 |

|---|

|

systemctl stop firewalld

|

永久关闭防火墙

| 代码块 |

|---|

|

systemctl disable firewalld

|

查看防火墙状态

| 代码块 |

|---|

|

systemctl status firewalld

|

2.开启防火墙

相关服务及端口对照表:

...

9864,9866,9867,9868,9870

如果确实需要打开防火墙安装,需要给防火墙放开以下需要使用到的端口

开启端口:9864,9866,9867,9868,9870

| 代码块 |

|---|

|

firewall-cmd --zone=public --add-port=9864/tcp --permanent

firewall-cmd --zone=public --add-port=9866/tcp --permanent

firewall-cmd --zone=public --add-port=9867/tcp --permanent

firewall-cmd --zone=public --add-port=9868/tcp --permanent

firewall-cmd --zone=public --add-port=9870/tcp --permanent

|

配置完以后重新加载firewalld,使配置生效

查看防火墙的配置信息

| 代码块 |

|---|

|

firewall-cmd --list-all

|

3.关闭selinux

临时关闭selinux,立即生效,不需要重启服务器。

永久关闭selinux,修改完配置后需要重启服务器才能生效

| 代码块 |

|---|

|

sed -i 's/=enforcing/=disabled/g' /etc/selinux/config |

1.2取消打开文件限制

修改/etc/security/limits.conf文件在文件的末尾加入以下内容:

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

vi /etc/security/limits.conf |

在文件的末尾加入以下内容:

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

* soft nofile 65536

* hard nofile 65536

* soft nproc 131072

* hard nproc 131072 |

2、Hadoop单节点安装

2.1 配置主机名映射

将数据挖掘组件中的服务器主机名映射到hosts文件中

文件末尾添(根据实际环境信息设置):

| 代码块 |

|---|

|

10.10.204.248 10-10-204-248

10.10.204.249 10-10-204-249

10.10.204.250 10-10-204-250 |

2.2 配置系统免密登录

登陆服务器,生成密钥

输入ssh-keygen后,连续按三次回车,不用输入其它信息。

复制公钥到文件中:

| 代码块 |

|---|

|

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys |

测试是否设置成功

示例:

| 代码块 |

|---|

|

ssh root@10-10-204-249 |

如果不用输入密码,表示配置成功

2.3 安装JAVA环境

解压jdk到指定目录:

| 代码块 |

|---|

|

tar -zxvf jdk-8u181-linux-x64.tar.gz -C /data |

添加环境变量

在文件末尾添加下面内容:

| 代码块 |

|---|

|

export JAVA_HOME=/data/jdk1.8.0_181

export JAVA_BIN=$JAVA_HOME/bin

export CLASSPATH=:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_BIN |

让配置生效

验证安装

2.4 安装Hadoop

2.4.1.准备hadoop数据目录

创建临时目录

| 代码块 |

|---|

|

mkdir -p /data/hdfs/tmp |

创建namenode数据目录

| 代码块 |

|---|

|

mkdir -p /data/hdfs/name |

创建datanode 数据目录

注意:这个目录尽量创建在空间比较大的目录,如果有多个磁盘,可以创建多个目录

| 代码块 |

|---|

|

mkdir -p /data/hdfs/data |

2.4.2.解压Hadoop到安装目录

| 代码块 |

|---|

|

tar -zxvf hadoop-3.2.2.tar.gz -C /data |

2.4.3.修改hadoop配置

①修改hadoop-env.sh

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/etc/hadoop

vi hadoop-env.sh |

找到"export JAVA_HOME",修改为如下所示(替换成实际环境的路径):

| 代码块 |

|---|

|

export JAVA_HOME=/data/jdk1.8.0_181 |

Image Removed

Image Removed

找到"export HDFS_NAMENODE_OPTS", 在下面添加一行

| 代码块 |

|---|

|

export HDFS_NAMENODE_OPTS="-XX:+UseParallelGC -Xmx4g" |

Image Removed

Image Removed

添加启动用户, 在文件最后添加以下内容

| 代码块 |

|---|

|

export HDFS_DATANODE_USER=root

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root |

Image Removed

Image Removed

...

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/etc/hadoop

vi core-site.xml |

内容如下:

| 代码块 |

|---|

|

<configuration>

<property>

<name>fs.defaultFS</name>

<!-- 注意替换成实际的主机名 -->

<value>hdfs://10-10-204-249:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<!-- 注意替换成实际的路径 -->

<value>file:/data/hdfs/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>100800</value>

</property>

<property>

<name>hadoop.security.authorization</name>

<value>true</value>

</property>

</configuration> |

④修改hdfs-site.xml

| 代码块 |

|---|

cd /data/hadoop-3.2.2/etc/hadoop

vi hdfs-site.xml |

内容如下:

| 代码块 |

|---|

|

<configuration>

<property>

<name>dfs.name.dir</name>

<!-- 注意替换成实际的路径 -->

<value>file:/data/hdfs/name</value>

</property>

<property>

<name>dfs.data.dir</name>

<!-- 注意替换成实际的路径 -->

<value>file:/data/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>false</value>

</property>

<property>

<name>dfs.datanode.max.transfer.threads</name>

<value>16384</value>

</property>

</configuration> |

| 注意 |

|---|

|

dfs.data.dir尽量配置在空间比较大的目录,可以配置多个目录,中间用逗号分隔 |

⑤修改hadoop-policy.xml

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

cd /data/hadoop-3.2.2/etc/hadoop

vi hadoop-policy.xml |

内容如下:

| 代码块 |

|---|

| language | xml |

|---|

| linenumbers | true |

|---|

|

<configuration>

<property>

<name>security.client.protocol.acl</name>

<value>*</value>

<description>ACL for ClientProtocol, which is used by user code

via the DistributedFileSystem.

The ACL is a comma-separated list of user and group names. The user and

group list is separated by a blank. For e.g. "alice,bob users,wheel".

A special value of "*" means all users are allowed.</description>

</property>

<!-- 这里把实验引擎ip, python执行节点ip,spark部署机器ip,hadoop部署机器ip都加上-->

<!-- 增加以下配置 -->

<property>

<name>security.client.protocol.hosts</name>

<value>10.10.204.248,10.10.204.249,10.10.204.250</value>

</property>

<!-- end -->

<property>

<name>security.client.datanode.protocol.acl</name>

<value>*</value>

<description>ACL for ClientDatanodeProtocol, the client-to-datanode protocol

for block recovery.

The ACL is a comma-separated list of user and group names. The user and

group list is separated by a blank. For e.g. "alice,bob users,wheel".

A special value of "*" means all users are allowed.</description>

</property>

<!-- 这里把实验引擎ip,python执行节点ip,spark部署机器ip,hadoop部署机器ip都加上-->

<!-- 增加以下配置 -->

<property>

<name>security.client.datanode.protocol.hosts</name>

<value>10.10.204.248,10.10.204.249,10.10.204.250</value>

</property>

<!-- end -->

<property>

<name>security.datanode.protocol.acl</name>

<value>*</value>

<description>ACL for DatanodeProtocol, which is used by datanodes to

communicate with the namenode.

The ACL is a comma-separated list of user and group names. The user and

group list is separated by a blank. For e.g. "alice,bob users,wheel".

A special value of "*" means all users are allowed.</description>

</property>

<!-- hadoop-policy.xml配置文件以上部分需要修改 -->

<!-- hadoop-policy.xml后续配置无需修改和添加,此处省略,避免文档篇幅过长 -->

<!-- ... -->

</configuration> |

| 注意 |

|---|

|

hadoop-policy.xml配置文件仅添加两处配置项; 新增的security.client.protocol.hosts,security.client.datanode.protocol.hosts两个配置项中的值,要替换成实际环境的IP地址; 此配置文件是限制可以访问hadoop节点的服务器ip,提高hadoop应用的安全性。 |

2.4.4.配置hadoop环境变量

在文件末尾添加下面内容:

| 代码块 |

|---|

|

export HADOOP_HOME=/data/hadoop-3.2.2

export PATH=$PATH:$HADOOP_HOME/bin |

让配置生效

2.4.5.启动Hadoop

①格式化hadoop

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/

./bin/hdfs namenode -format |

| 注意 |

|---|

仅第一次启动时需要执行格式化Hadoop操作,后续启动无需进行此操作 |

②启动hadoop

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/

./sbin/start-dfs.sh |

③创建中间数据存储目录

| 代码块 |

|---|

hdfs dfs -mkdir /mining

hdfs dfs -chown mining:mining /mining |

2.4.6.验证安装

①在浏览器输入: http://HadoopIP:9870/dfshealth.html#tab-overview 检查集群状态

Image Removed

Image Removed

Image Removed

Image Removed

②检查mining目录是否创建成功

| 代码块 |

|---|

|

hdfs dfs -ls / #显示创建的/mining即表示创建成功 |

2.5 运维操作

停止hadoop

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/

./sbin/stop-dfs.sh |

启动hadoop

| 代码块 |

|---|

|

cd /data/hadoop-3.2.2/

./sbin/start-dfs.sh |

查看日志

hadoop的日志路径:/data/hadoop-2.7.3/logs

安装部署或者使用中有问题,可能需要根据日志来分析解决。

...

3、设置执行引擎连接Hadoop

浏览器访问smartbi,打开系统运维--数据挖掘配置–执行引擎–引擎配置 找到“节点数据hdfs存储目录”配置项,填写Hadoop地址

Image Removed

Image Removed

| 注意 |

|---|

|

如果是Hadoop集群,上图中节点数据hdfs存储目录需要填写Hadoop管理节点的IP |

4、Python执行节点更新

4.1停止旧Python服务

进入安装Python计算节点的服务器,进入目录,停止Python服务

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

cd /opt/smartbi-mining-engine-bin/engine/sbin

./python-daemon.sh stop |

| 注意 |

|---|

|

注意,如果出现无法停止情况,可以通过jps查看python服务进程id,然后 kill -9 进程id |

4.2更新引擎包

更新方式,参考数据挖掘的更新方式,如果python执行节点跟实验引擎在同台机器,这步骤可以省略

4.3添加主机名映射

将数据挖掘组件中的服务器主机名映射到hosts文件中

文件末尾添(根据实际环境信息设置):

| 代码块 |

|---|

|

10.10.204.248 10-10-204-248

10.10.204.249 10-10-204-249

10.10.204.250 10-10-204-250 |

4.4.创建Python执行用户

创建用户组、用户并设置密码

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

groupadd mining #创建mining组

useradd -g mining mining-ag #创建启动用户(mining-ag)并指定用户组为mining

passwd mining-ag #设置mining-ag用户密 |

给引擎安装目录附权限(为了使用mining-ag用户启动执行代理程序时候,有权限创建agent-data跟agent-logs目录)

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

chgrp mining /data/smartbi-mining-engine-bin

chmod 775 /data/smartbi-mining-engine-bin |

4.5.启动Python执行代理

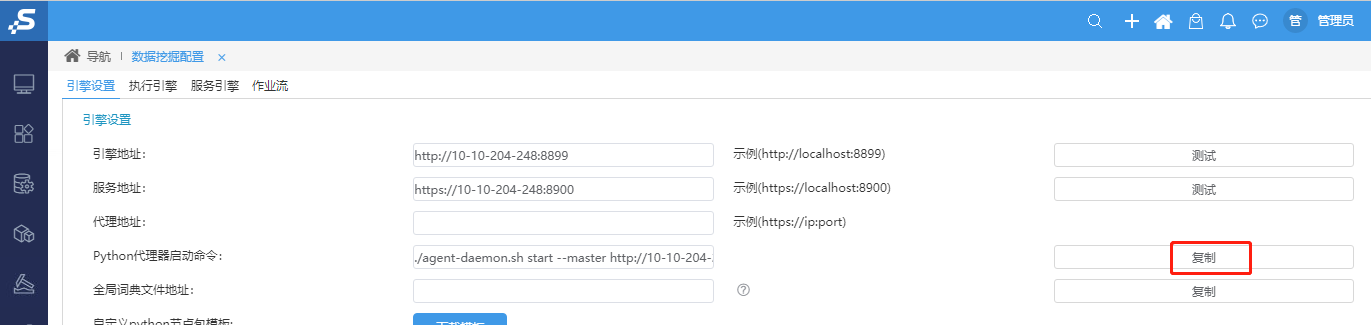

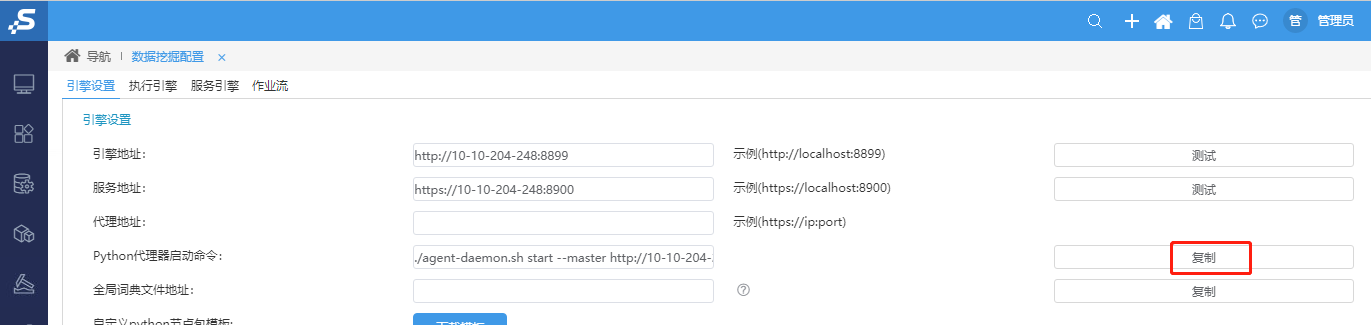

①浏览器访问Smartbi,打开系统运维–数据挖掘配置–引擎设置,复制Python代理器启动命令

Image Removed

Image Removed

| 注意 |

|---|

|

复制Python代理器启动命令前,请确认数据挖掘引擎能正常测试连接成功 |

②登录到部署Python节点机器,并切换到mining-ag用户

| 注意 |

|---|

|

为了避免出现安全问题,一定要切换到mining-ag用户去启动执行代理服务,不要使用root用户安装或带有sudo权限的用户来启动执行代理服务 |

| 代码块 |

|---|

| language | bash |

|---|

| linenumbers | true |

|---|

|

su - mining-ag |

进入引擎启动目录

| 代码块 |

|---|

|

cd /data/smartbi-mining-engine-bin/engine/sbin |

把拷贝命令粘贴,并执行,例如:

| 代码块 |

|---|

|

./agent-daemon.sh start --master http://10-10-204-248:8899 --env python |

等待Python节点启动成功即可。

4.6.运维操作

1、更新Python数据挖掘引擎包

Smartbi更新war包版本时,Python执行节点需要同步更新对应版本的数据挖掘引擎。

...

一、Windows EXE 部署

1. 覆盖升级

通过执行V10的EXE安装文件,可以对已安装的V95环境进行覆盖升级操作,具体可参考文档 Windows 客户端升级指南。

2. 切换高速缓存库

使用管理员初次访问升级后的V10环境,系统会进行自检,当检测到当前的高速缓存库为Infobright时:

① 为了确保新功能的正常使用,则会提醒用户重新配置高速缓存库。此时请参考文档切换高速缓存库,重新抽取。

② 如需正常访问原本基于Infobright建立的资源,请参考文档 Infobright 数据迁移到 SmartbiMppForWindows 进行数据迁移。

二、Linux Tomcat 部署

1. Smartbi更新

向Smartbi官方获取V10版本的Smartbi安装包。更新的详细方法,请参考:War包更新方法

2. 部署Smartbi OLAP Server

Smartbi OLAP Server为新增组件,详细的OLAP Server部署,请参考:Window部署、linux部署

3. 部署高速缓存库

① 初次部署

初次部署高速缓存库的请参考文档 部署Smartbi-MPP高速缓存库。

② 更新MPP

| 注意 |

|---|

SmartbiMPP支持 21.x及以上版本,若低于该版本则需进行更新 |

更新SmartbiMPP请参考文档 升级SmartbiMPP。

③ 切换高速缓存库

使用管理员初次访问升级后的V10环境,系统会进行自检,当检测到当前的高速缓存库为infobright时:

① 为了确保新功能的正常使用,则会提醒用户重新配置高速缓存库。此时请参考文档切换高速缓存库,重新抽取。

② 如需正常访问原本基于Infobright建立的资源,请参考文档 Infobright数据迁移到SmartbiMPP 进行数据迁移。

4. 数据挖掘版本更新

| 注意 |

|---|

① 数据挖掘引擎安装包版本要和Smartbi的war包版本一致; ② 更新时需要同步更新Python节点中的挖掘引擎包。 |

本次升级更新内容如下:

- Spark从2.4更新到3.1;

- 新增Hadoop组件;

数据挖掘各组件更新方法请参考:【数据挖掘】V9.5升级到V10版本