| 锚 | ||||

|---|---|---|---|---|

|

概述

文本数据源是指将HDFS读取的csv等数据文件导入到Smartbi中。

输入/输出

输入 | 没有输入端口。 |

|---|---|

| 输出 | 只有一个输出端口,用于输出数据到下一节点资源。 |

参数配置

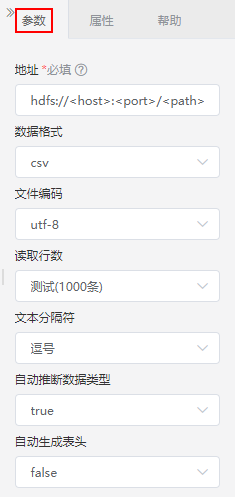

设置文本数据源的参数:

设置说明如下:

| 参数 | 说明 |

|---|---|

| 地址 | 文本数据在HDFS的路径,其中:

|

| 数据格式 | 选择文本的数据格式:csv、json、parquet、apache.orc。 |

| 文件编码 | 选择当前数据文件的编码格式:GBK或UTF-8。 |

| 读取行数 | 选择用于当前工作流的数据量:测试1000条、全部。 |

文本分隔符 | 选择当前数据文件中的分隔符:逗号、分号、空格、tab、竖线。 |

| 自动推断数据类型 | 若需要自动判断数据源中字段的数据类型,则选true,否则选false。 |

| 自动生成表头 | 表示上传数据时是否生成表头:若上传数据时没有表头,则选ture,系统自动生成表头;否则选false。 |

Kafka数据源

概述

Kafka数据源是指从kafka读取数据。

输入/输出

输入 | 没有输入端口。 |

|---|---|

| 输出 | 只有一个输出端口,用于输出数据到下一节点资源。 |

参数配置

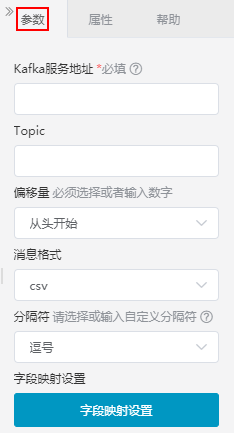

设置说明如下:

| 参数 | 说明 |

|---|---|

| Kafka服务地址 | 连接Kafka的地址。 |

| Topic | 订阅的主题,一个topic可以看做为kafka中的一类消息。 |

| 偏移量 | 每条消息在文件中保存的位置被称为偏移量(offset),从指定的起点开始消费kafka数据。注:必须选择或者输入数字

|

| 消息格式 | 支持csv跟json格式,如果是csv格式,需要设置分隔符跟字段映射。 |

| 锚 | ||||

|---|---|---|---|---|

|

概述

关系数据源是指从Smartbi关系数据源中读取的库表数据。

| 信息 | ||

|---|---|---|

| ||

目前支持Infobright、ClickHouse、Vertica、Oracle、MySQL、DB2、MSSQL、Presto、Hadoop_Hive、Guass100、PostgreSQL、Greenplum(V9.5目前不支持Greenplum数据库)、星环(V9.5目前不支持星环数据库)、达梦(V9.5目前不支持达梦数据库,V9.7支持6、7.1、7.6版本的达梦数据库)、GBase(V9.5目前不支持GBase数据库,V9.7支持8A、8S V8.4、8S V8.8版本的GBase数据库)、Sybase、HANA。 |

输入/输出

输入 | 没有输入端口。 |

|---|---|

| 输出 | 只有一个输出端口,用于输出数据到下一节点资源。 |

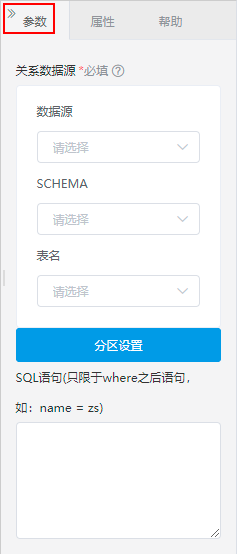

参数配置

设置关系数据源的参数:

设置说明如下:

参数 | 说明 |

|---|---|

| 数据源 | 选择数据源,这些数据源是Smartbi中连接配置好的关系数据源。 |

| SHEMA | 选择SHEMA。 |

| 表名 | 选择表。 |

| 分区设置 | |

| SQL语句 | 通过SQL语句设置where条件,过滤出表中的数据用于工作流。 |

| 锚 | ||||

|---|---|---|---|---|

|

分区设置

把表数据相对平均分成多个分区,抽取程序会尽可能一个分区分配一个线程进行并行抽取,能够极大的提高大数据量情况下的数据抽取性能。

如图设置分区字段“累计治愈”的分区数量为4,最小值为1,最大值为20,则系统会以(-∞,5)、[5,10)、[10,15)、[15,+∞)这4个区间来并行读取数据,提升数据抽取性能。

- 分区字段(必填):分区字段为数值型(不支持浮点型)、日期类型。

- 分区数量(必填):设置抽取分区的数量,正整数。

- 分区字段最小值/分区字段最大值(必填):在设置的最小值和最大值的区间中抽取数据。

分区字段的选取:

选择的字段尽可能把数据按照不同区间,相对平均分成多个分区。

在分区表中,可以选择创建分区表时选择的字段作为分区字段。如果不是分区表,建议选取一些比较有区分度的字段。例如在一张用户表中,“年龄”比“性别”字段更具有区分度,因此可以选择“年龄”作为分区字段。

使用场景:在一家互联网类企业中,用户使用产品的日志表按天或按季度做成的分区表,可以通过分区抽取数据,提升抽取性能。

| 锚 | ||||

|---|---|---|---|---|

|

概述

示例数据源是指从系统中读取内置的示例数据源。

输入输出

| 输入 | 没有输入端口。 |

|---|---|

| 输出 | 只有一个输出端口,用于输出数据到下一节点资源。 |

参数配置

设置示例数据源的参数:

设置说明如下:

| 参数 | 说明 |

|---|---|

| 数据源选择 | 选择平台内置的示例数据源 |

| 锚 | ||||

|---|---|---|---|---|

|

概述

数据集是指从Smartbi中读取数据集中的数据,包含:可视化数据集、SQL数据集、原生SQL数据集、Java数据集、存储过程数据集、多维数据集、自助数据集。

输入输出

| 输入 | 没有输入端口。 |

|---|---|

| 输出 | 只有一个输出端口,用于输出数据到下一节点资源。 |

参数配置

设置数据集的参数:

设置说明如下:

参数 | 说明 |

|---|---|

| 请选择数据集 | 用于单击按钮后,在“数据集选择”窗口中选择Smartbi中已定义的数据集。 |

| 新建数据集 | 用于新建指定类型的数据集,选择数据集后,跳转到指定数据集的新建界面;可选的数据集类型有:自助数据集、原生SQL数据集、可视化数据集、存储过程数据集、Java数据集、多维数据集。 |

| 编辑已选数据集 | 用于编辑选择的数据集,单击按钮后,会跳转到指定数据集的编辑界面。 |

| 数据更新设置 | 用于设置数据集是否需要重新抽取:“更新抽取数据”表示需要重新抽取;“使用已抽取数据”表示不需要重新抽取。 |

Excel文件数据源

概述

Excel文件数据源是指将Excel文件中的数据导入到Smartbi中。

- 上传Excel文件:用于上传excel文件;

- 读取Excel sheet:用于读取指定sheet页的数据,只能接在上传Excel文件节点后面。

操作步骤

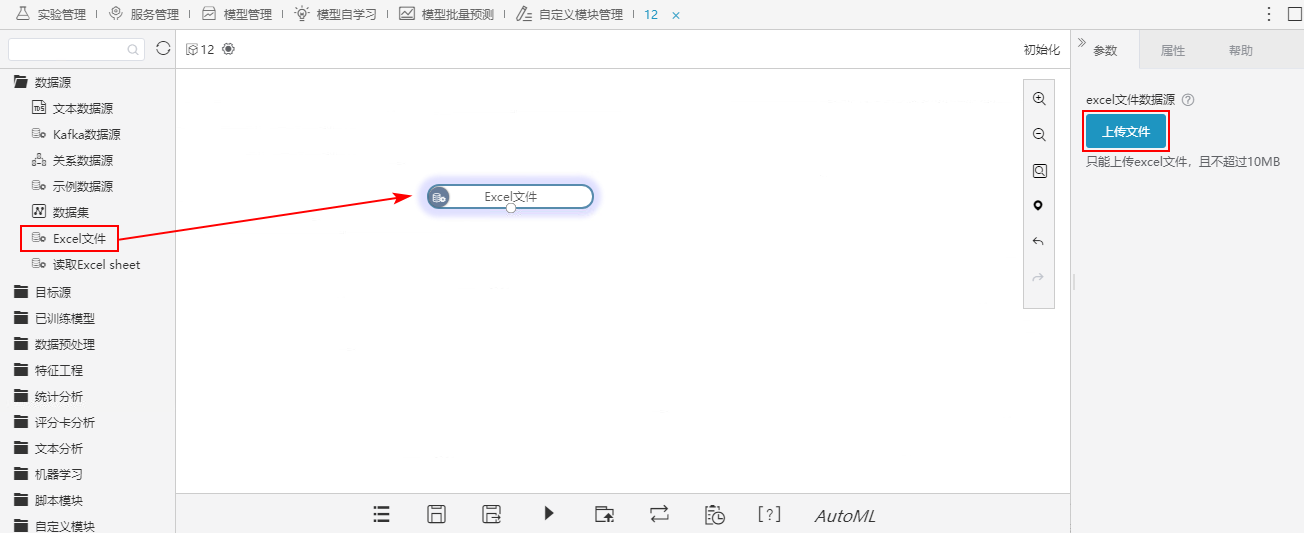

1、将Excel文件节点拖入画布区,点击 上传文件 按钮,上传Excel文件。

2、上传完成后,右键运行此节点。

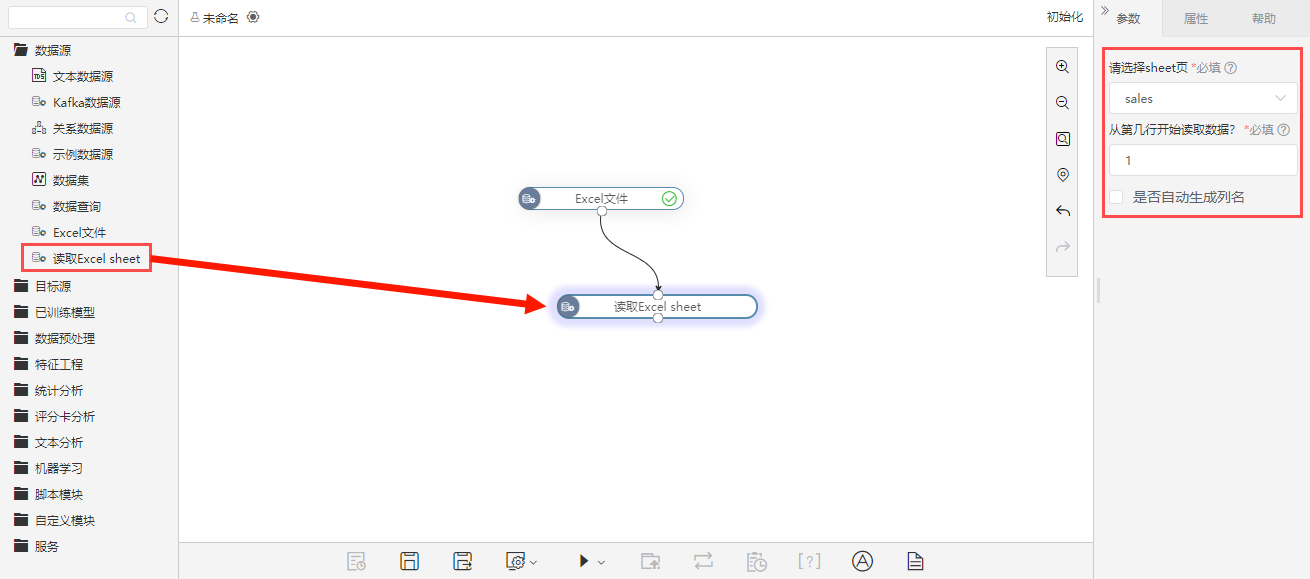

3、将读取Excel sheet节点拖入画布区,配置参数,完成后运行此节点。

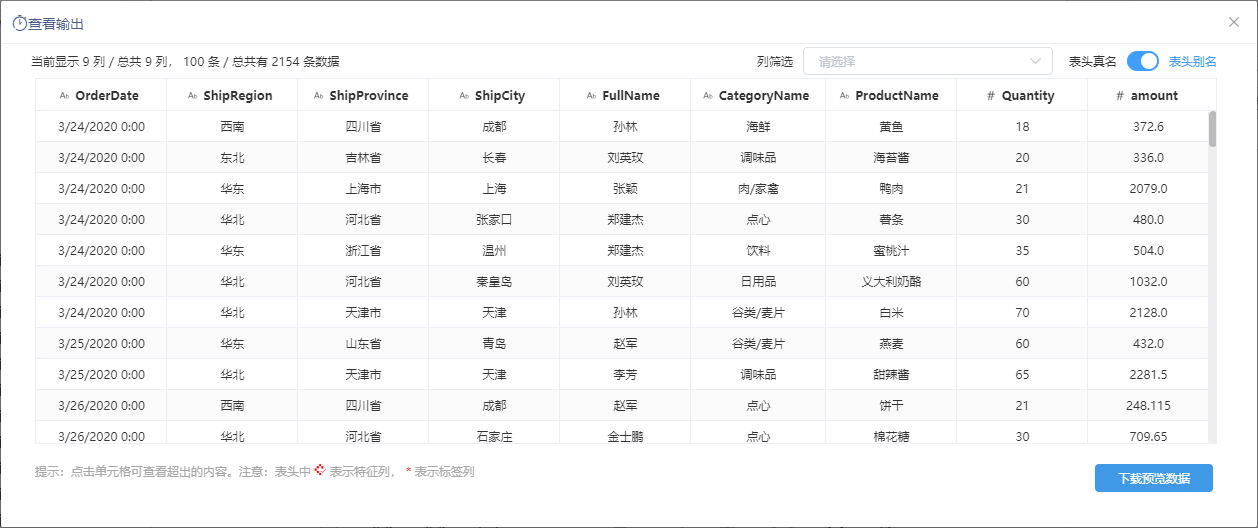

4、查看输出的数据如下:

设置说明如下:

| 节点 | 参数 | 说明 |

|---|---|---|

| Excel文件 | 上传文件 | 上传Excel文件到服务器引擎,文件大小不超过10M。 |

| 读取Excel sheet | 请选择sheet页 | 选择需要的sheet页。 |

| 从第几行开始读取数据? | 设置从第几行开始读取数据。 | |

| 是否自动生成列名 | 选择是否自动生成列名。 |

| 锚 | ||||

|---|---|---|---|---|

|

目标源

Smartbi提供了4种方式用于数据的输出,分别是关系目标表(追加)、关系目标表(覆盖)、关系目标表(插入或更新)、导出数据到HDFS,支持将数据导出到目标库中。

| 锚 | ||||

|---|---|---|---|---|

|

概述

关系目标表通过追加、覆盖、插入或更新的方式将结果数据保存到Smartbi的关系数据源中。

| 类型 | 说明 | ||

|---|---|---|---|

| 在原数据的基础上增加新的数据。 | |||

| 用新的数据对原数据进行覆盖。 | |||

对数据库原有的数据进行更新,对数据库不存在的数据进行插入。

|

| 信息 |

|---|

目前支持Infobright、ClickHouse、Vertica、Oracle、MySQL、DB2、MSSQL、PostgreSQL、Guass100、Greenplum(V9.5目前不支持Greenplum数据库)、星环(V9.5目前不支持星环数据库)、达梦(V9.5目前不支持达梦数据库,V9.7支持6、7.1、7.6版本的达梦数据库)、GBase(V9.5目前不支持GBase数据库,V9.7支持8A、8S V8.4、8S V8.8版本的GBase数据库)、Sybase、HANA。 |

输入输出

| 输入 | 只有一个输入端口,用于将接收到的结果数据存储到指定库中。 |

|---|---|

| 输出 | 没有输出端口。 |

参数配置

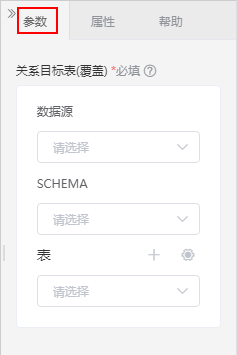

关系目标源(追加)的参数:

关系目标源(覆盖)的参数:

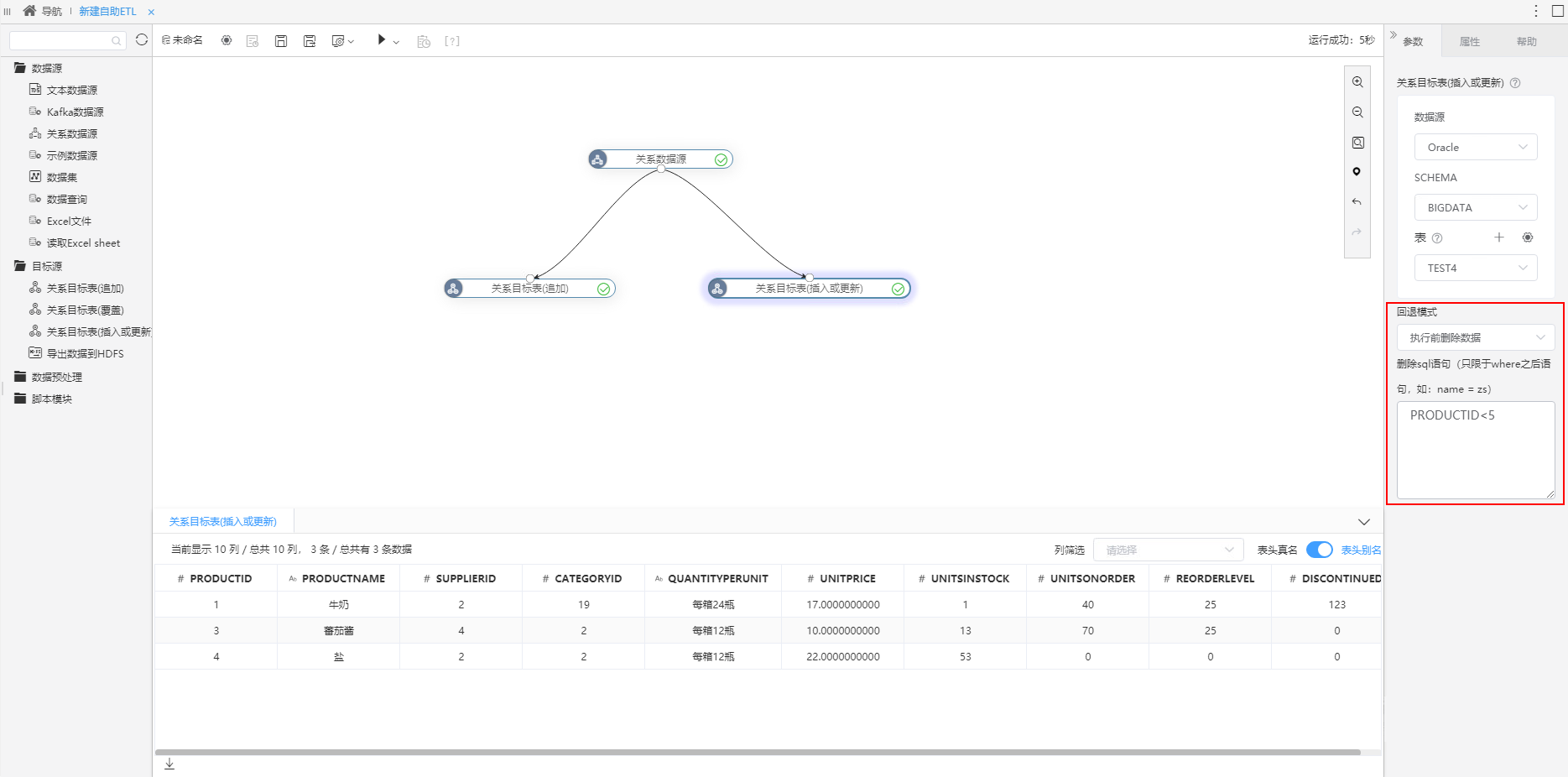

关系目标源(插入或更新)的参数:

参数说明如下:

| 参数 | 说明 | ||

|---|---|---|---|

| 数据源 | 选择数据源,这些数据源是在Smartbi中连接的关系数据源。 | ||

| SCHEMA | 在选择的数据源中选择SHEMA。 | ||

| 表 | 选择表。选择数据源和SCHEMA之后,可以选择新建一张表,也可以在下拉框中选择已有的表。 | ||

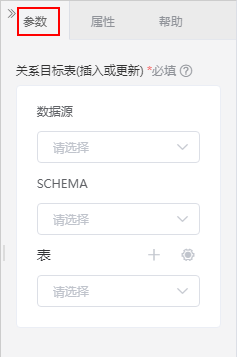

| 回退模式 | 关系目标表(追加)、关系目标表(插入或更新)节点支持回退模式功能。

在删除SQL语句框中,填写where之后的删除语句(条件SQL使用表头真名): 注意: 1、目前只有ClickHouse数据源(19.4.2.7版本及以上)支持回退模式功能。 2、如果是新建的表,则表中不能有值为NULL的数据。

|

| 锚 | ||||

|---|---|---|---|---|

|

回退模式用于在插入数据前先把满足条件的数据删除,可实现增量删除。

- 无(默认);

- 执行前删除数据:根据填写的删除sql语句条件,可实现在插入数据前先把满足条件的数据删除掉。

在参数设置区中,回退模式选择”执行前删除数据“,在删除sql语句框中填写删除语句(条件SQL使用表头真名)。

如上图,根据条件会先删除”PRODUCTID<5“的数据,然后根据节点功能更新、追加数据:关系目标表(追加)节点会直接追加新增的数据;关系目标表(插入或更新)节点会先更新原有的数据,然后再插入新增的数据。

| 锚 | ||||

|---|---|---|---|---|

|

概述

导出数据到HDFS是指将结果数据保存到HDFS中。

输入输出

| 输入 | 只有一个输入端口,用于将接收到的结果数据存储到HDFS中。 |

|---|---|

| 输出 | 没有输出端口。 |

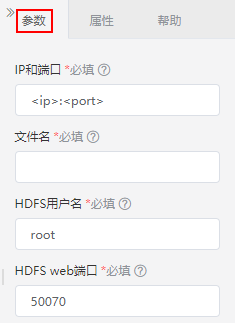

参数配置

设置导出数据到HDFS的参数:

设置说明如下:

| 参数 | 说明 |

| IP和端口 | 目标HDFS的路径的IP和端口:<ip>:<port>; 示例:10.10.202.26:9000。 |

| 文件名 | 存储到HDFS的数据文件名。 |

| HDFS用户名 | HDFS用户名。 |

| HDFS web端口 | HDFS web端口,默认是50070。 |

输出到数据集

概述

输出到数据集是指将结果数据以自助数据集的形式保存到Smartbi中。

输入输出

| 输入 | 只有一个输入端口,用于将接收到的结果数据存储到自助数据集中。 |

|---|---|

| 输出 | 没有输出端口。 |

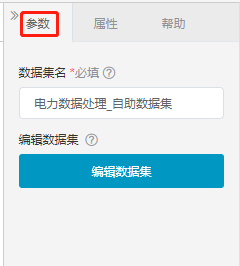

参数配置

设置自助数据集的参数:

输出的自助数据集默认命名为"自助ETL名称_自助数据集"。

该自助数据集只有一张表,可以通过"编辑数据集"按钮对该自助数据集进行编辑: