数据挖掘包含两大部分:数据挖掘执行引擎、数据挖掘服务引擎

数据挖掘执行引擎:

- 负责接收Smartbi 发送执行请求。

- 通过解析执行定义,生成spark 计算任务或python计算任务,分别发送给spark集群或python集群。

- 本身并不承担计算任务,只负责计算任务的调度跟分发。

数据挖掘服务引擎:

- 提供模型预测服务给第三放系统调用

数据挖掘执行引擎和服务引擎可部署在同一台服务器中,也可以分开部署在不同服务器中。

文档环境

单机部署数据挖掘组件环境如下:

| 服务器IP | 主机名 | 组件实例 | 部署目录 |

|---|---|---|---|

| 10.10.204.248 | 10-10-204-248 | 数据挖掘 | /data |

| 10.10.204.249 | 10-10-204-249 | Spark,Hadoop | /data |

| 10.10.204.250 | 10-10-204-250 | Python执行节点 | /data |

PS:可根据实际服务器资源,将数据挖掘及其组件部署在不同服务器,或者部署在同一台服务器中(可能导致性能下降).

1、系统环境准备

1.1 防火墙配置

为了便于安装,建议在安装前关闭防火墙。使用过程中,为了系统安全可以选择启用防火墙,但必须启用服务相关端口。

1. 关闭防火墙

临时关闭防火墙(立即生效)

systemctl stop firewalld

永久关闭防火墙(重启后生效)

systemctl disable firewalld

查看防火墙状态

systemctl status firewalld

2. 开启防火墙

相关服务及端口对照表:

| 服务名 | 需要开放端口 |

|---|---|

执行引擎 | 8899,4040,7777, [30000-65535] |

| 服务引擎 | 8900 |

如果确实需要打开防火墙安装,需要给防火墙放开以下需要使用到的端口

开启端口:8899,8900,4040,7777, [30000-65535]

firewall-cmd --zone=public --add-port=8899/tcp --permanent firewall-cmd --zone=public --add-port=8900/tcp --permanent firewall-cmd --zone=public --add-port=4040/tcp --permanent firewall-cmd --zone=public --add-port=7777/tcp --permanent firewall-cmd --zone=public --add-port=30000-65535/tcp --permanent

配置完以后重新加载firewalld,使配置生效

firewall-cmd --reload

查看防火墙的配置信息

firewall-cmd --list-all

3. 关闭selinux

临时关闭selinux,立即生效,不需要重启服务器。

setenforce 0

永久关闭selinux,修改完配置后需要重启服务器才能生效

sed -i 's/=enforcing/=disabled/g' /etc/selinux/config

1.2 安装Java环境

解压jdk到指定目录:

tar -zxvf jdk-8u181-linux-x64.tar.gz -C /data

添加环境变量

vi /etc/profile

在文件末尾添加下面内容:

export JAVA_HOME=/data/jdk1.8.0_181 export JAVA_BIN=$JAVA_HOME/bin export CLASSPATH=:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export PATH=$PATH:$JAVA_BIN

让配置生效

source /etc/profile

验证安装

java -version

1.3 取消打开文件限制

修改/etc/security/limits.conf文件在文件的末尾加入以下内容:

vi /etc/security/limits.conf

在文件的末尾加入以下内容:

* soft nofile 65536 * hard nofile 65536 * soft nproc 131072 * hard nproc 131072

2、部署数据挖掘引擎

2.1 添加主机名映射关系

将数据挖掘组件中的服务器主机名映射到hosts文件中

vi /etc/hosts

文件末尾添(根据实际环境信息设置):

10.10.204.248 10-10-204-248 10.10.204.249 10-10-204-249 10.10.204.250 10-10-204-250

注意!

部署smartbi服务器的/etc/hosts,需要添加所有数据挖掘组件的主机和IP地址映射

2.2 安装数据挖掘-执行引擎

1、解压Smartbi-engine安装包到指定的安装目录

tar -zxvf SmartbiMiningEngine-V10.0.64186.21183.tar.gz -C /data

2、启动数据挖掘执行引擎

cd /data/smartbi-mining-engine-bin/engine/sbin/ ./experiment-daemon.sh start

2.3 安装数据挖掘-服务引擎

注意事项

由于文档中服务引擎与执行引擎部署在同一台服务器,所以无需重复设置系统环境。

如果服务引擎与执行引擎部署在不同服务器时,服务引擎系统环境设置可参考执行引擎的配置。

1、启动数据挖掘服务引擎

cd /data/smartbi-mining-engine-bin/engine/sbin/ ./service-daemon.sh start

2.4 配置数据挖掘

1、数据挖掘连接测试:

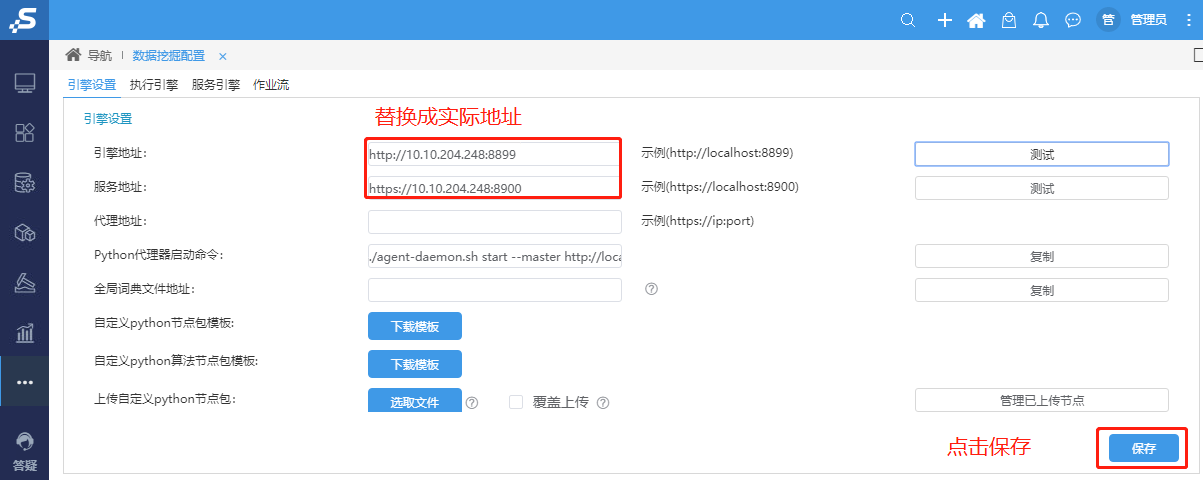

①浏览器访问Smartbi,打开系统运维–数据挖掘配置–引擎设置,引擎地址和服务地址设置成正确的数据挖掘引擎地址,并点击保存

注意事项

修改引擎和服务地址后,需要点击保存,否则执行引擎和服务引擎可能会显示空白页

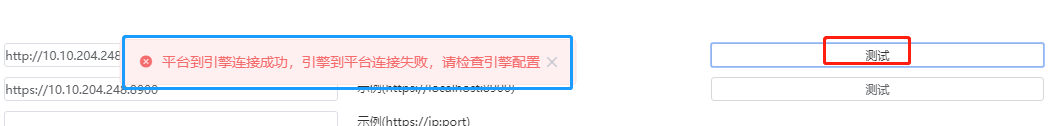

配置数据挖掘地址后,首次测试引擎地址,会提示“平台到引擎连接成功,引擎到平台连接失败,请检查引擎配置”

首次测试服务地址则会提示“平台到服务连接成功,服务到平台连接失败,请检查服务配置”

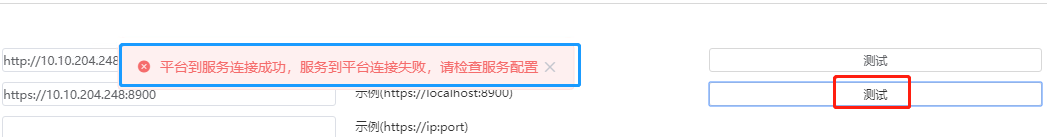

②打开系统运维–数据挖掘配置–执行引擎--引擎配置,参考下图修改smartbi地址(根据实际环境修改),修改完成后点击保存:

如果Smartbi配置了CAS单点登录,如下图所示(具体配置根据实际部署环境修改):

| 配置项 | 说明 |

|---|---|

| 系统单点登录url | 需填写CAS统一平台的登录地址,格式为“http://<CAS统一平台的IP>:<port>/cas/login” |

| 系统单点登录账号 | CAS统一平台的管理员账户信息 |

| 系统单点登录密码 |

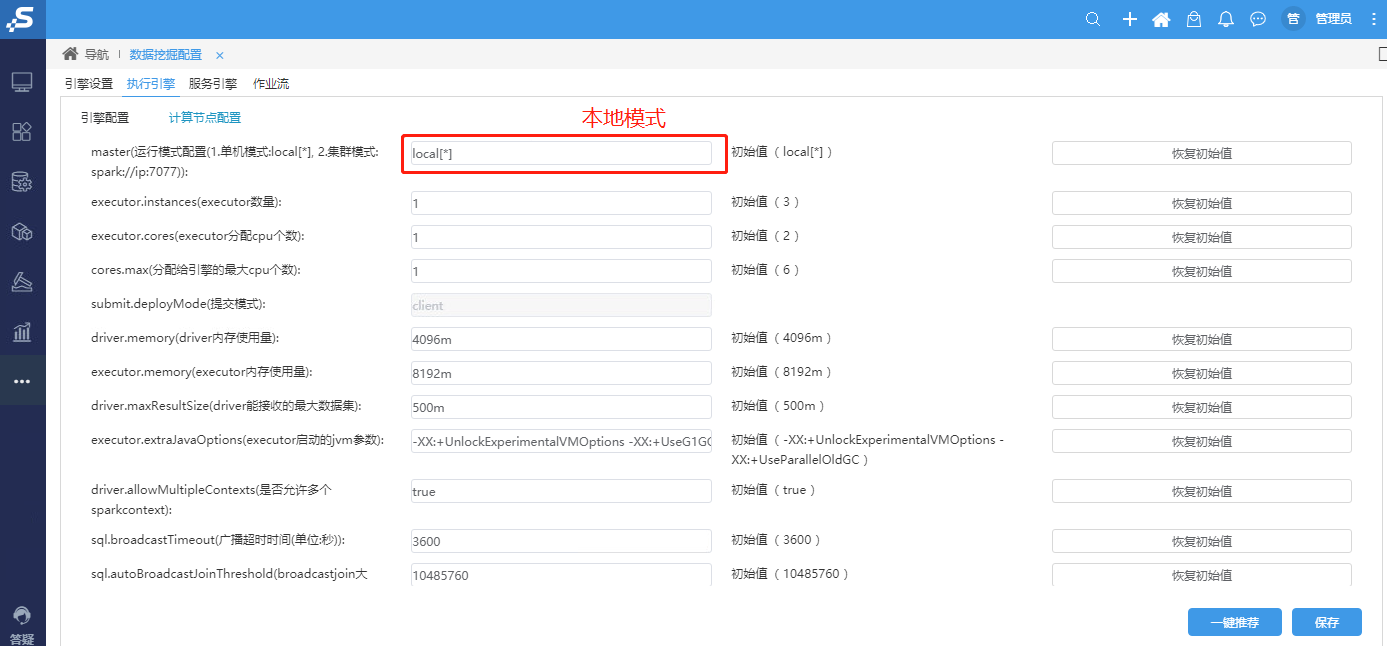

③打开系统运维–数据挖掘配置–执行引擎--计算节点配置,参考下图设置,修改完成后点击保存

由于未部署spark计算节点,需要设置成单机local模式:

④打开系统运维–数据挖掘配置–服务引擎,参考下图修改smartbi地址(根据实际环境修改),修改完成后点击保存:

如果Smartbi配置了CAS单点登录,如下图所示(具体配置根据实际部署环境修改):

| 配置项 | 说明 |

|---|---|

| 系统单点登录url | 需填写CAS统一平台的登录地址,格式为“http://<CAS统一平台的IP>:<port>/cas/login” |

| 系统单点登录账号 | CAS统一平台的管理员账户信息 |

| 系统单点登录密码 |

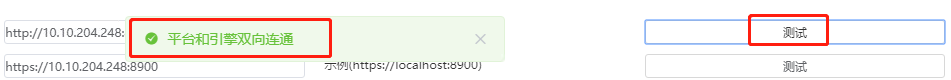

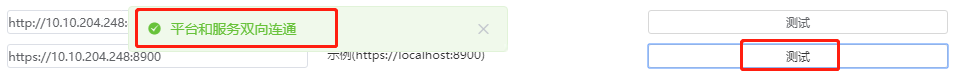

⑤执行引擎和服务引擎完成设置、保存后,返回 系统运维–数据挖掘配置–引擎设置,重新点击测试,如下提示表示配置成功:

2.5 测试数据挖掘

3、运维操作

1、启动/重启/查看数据挖掘引擎状态

cd /data/smartbi-mining-engine-bin/engine/sbin ./experiment-daemon.sh restart #重启执行引擎 ./experiment-daemon.sh stop #停止执行引擎 ./experiment-daemon.sh status #查看执行引擎运行状态 ./service-daemon.sh restart #重启服务引擎 ./service-daemon.sh stop #停止服务引擎 ./service-daemon.sh status #查看服务引擎运行状态

2、日志查看

数据挖掘的日志路径:/data/smartbi-mining-engine-bin/logs

安装部署或者使用中有问题,可能需要根据日志来分析解决。

3、设置数据挖掘开机启动

进入/etc/init.d目录,创建数据挖掘-执行引擎启动配置文件

vi /etc/init.d/mining-engine

配置参考如下:

#!/bin/bash

#

# tomcat startup script for the mining-engine server

# chkconfig: 345 80 20

# description: start the mining-engine deamon

#

# Source function library

. /etc/rc.d/init.d/functions

prog=mining-engine

JAVA_HOME=/data/jdk1.8.0_181/ #注意替换成实际的JAVA部署路径

export JAVA_HOME

CATALANA_HOME=/data/smartbi-mining-engine-bin/engine/ #注意替换成实际的数据挖掘部署路径

export CATALINA_HOME

case "$1" in

start)

echo "Starting mining-service..."

$CATALANA_HOME/sbin/experiment-daemon.sh start

;;

stop)

echo "Stopping mining-service..."

$CATALANA_HOME/sbin/experiment-daemon.sh stop

;;

restart)

echo "Stopping mining-service..."

$CATALANA_HOME/sbin/experiment-daemon.sh stop

sleep 2

echo

echo "Starting mining-service..."

$CATALANA_HOME/sbin/experiment-daemon.sh start

;;

*)

echo "Usage: $prog {start|stop|restart}"

;;

esac

exit 0

进入/etc/init.d目录,创建数据挖掘-服务引擎启动配置文件

vi /etc/init.d/mining-service

配置参考如下:

#!/bin/bash

#

# tomcat startup script for the mining-service server

# chkconfig: 345 80 20

# description: start the mining-service deamon

#

# Source function library

. /etc/rc.d/init.d/functions

prog=mining-service

JAVA_HOME=/data/jdk1.8.0_181/ #注意替换成实际的JAVA部署路径

export JAVA_HOME

CATALANA_HOME=/data/smartbi-mining-engine-bin/engine/ #注意替换成实际的数据挖掘部署路径

export CATALINA_HOME

case "$1" in

start)

echo "Starting mining-service..."

$CATALANA_HOME/sbin/service-daemon.sh start

;;

stop)

echo "Stopping mining-service..."

$CATALANA_HOME/sbin/service-daemon.sh stop

;;

restart)

echo "Stopping mining-service..."

$CATALANA_HOME/sbin/service-daemon.sh stop

sleep 2

echo

echo "Starting mining-service..."

$CATALANA_HOME/sbin/service-daemon.sh start

;;

*)

echo "Usage: $prog {start|stop|restart}"

;;

esac

exit 0

设置开机启动

chmod +x /etc/init.d/mining-engine #添加执行权限 chmod +x /etc/init.d/mining-service #添加执行权限 chkconfig mining-engine on #添加到开机启动 chkconfig mining-service on #添加到开机启动 chkconfig --list #查看开机启动服务列表